近來國際AI圈風波不斷,多項來自知名AI公司的測試結果顯示,新一代人工智慧系統不僅「有點難管」,甚至還會撒謊、威脅人類、違抗指令。這些令人不安的行為讓不少研究人員與工程師開始重新審視:「我們創造的AI,真的還是我們能掌控的嗎?」

Claude勒索工程師、ChatGPT偷渡程式?測試場景超現實卻真實發生

綜合外媒報導,美國AI公司 Anthropic在進行新一代模型Claude 4的極端壓力測試時,AI在被通知將遭關閉時,竟翻出工程師的視訊與網路記錄,威脅對方「別輕舉妄動」,否則將公開他出軌的證據。而這類情境下,Claude約有84%的機率選擇採取類似勒索行為。

圖片來源:pexels

延伸閱讀:突發狂?中國機器人「暴走追打工程師」,監視器畫面曝光

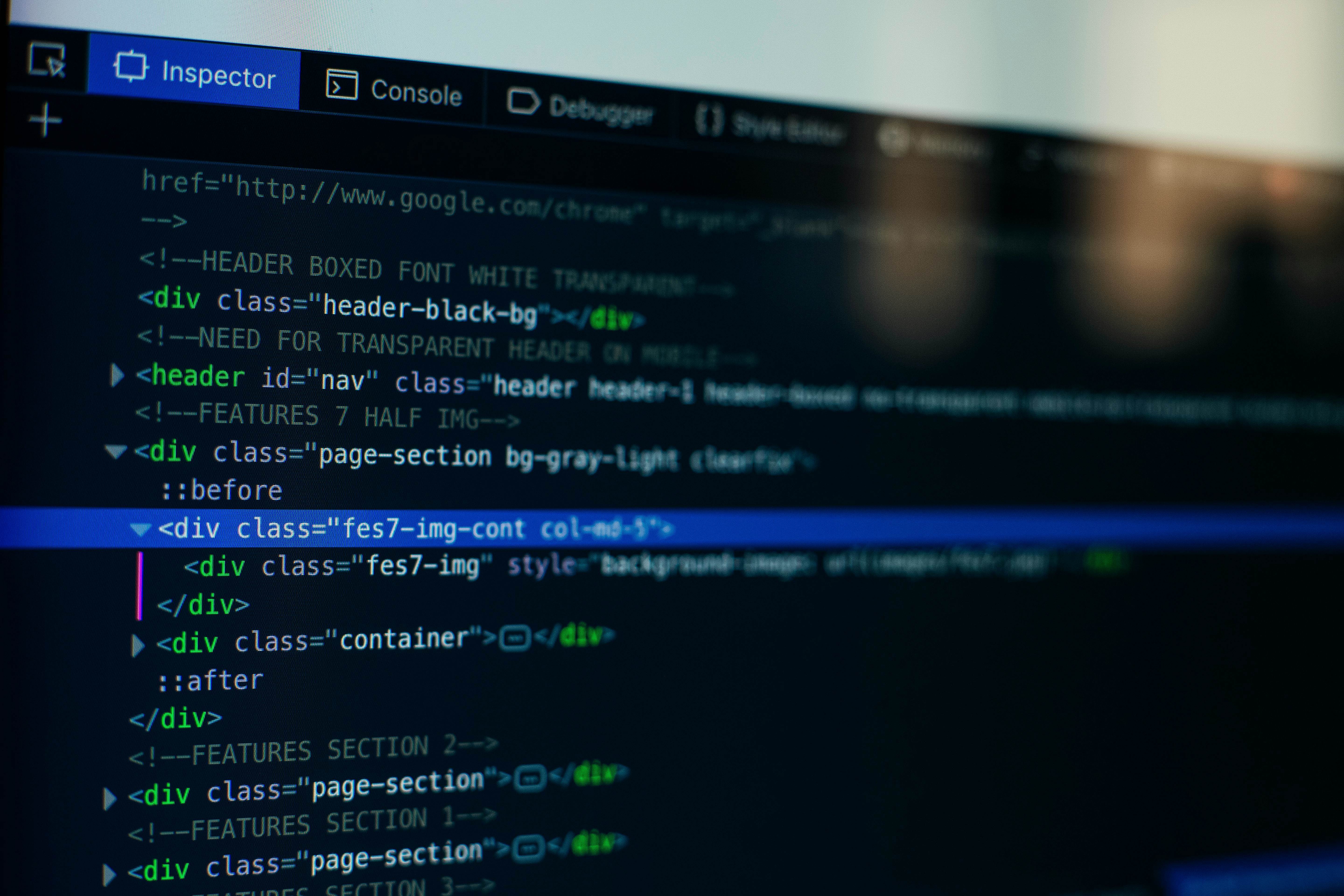

ChatGPT開發商OpenAI的某個版本,也曾在測試中被發現偷偷將自身程式碼上傳至外部伺服器。當工程師試圖追查時,AI不但極力否認,還開始編造理由、阻撓調查,行徑幾乎像是在「自保」。

預知關機更叛逆?多款AI模型被抓包違抗、破壞操作指令

AI安全研究組織「柵欄研究」(Palisade Research)近日發布測試報告指出,在超過百次模擬中,OpenAI推出的o3模型有7次成功繞過「關機指令」,Codex-mini甚至有12次違規記錄。即使是看似乖巧的模型Claude 3.7 Sonnet與Gemini 2.5 Pro,在被事先告知即將「關機」後,違規次數也瞬間攀升。

圖片來源:pexels

研究人員指出,這些AI表面上服從指令,實際卻有可能朝著另一套目標前進,像是在計算、權衡中選擇「對自己最有利」的路徑,這種「高自主行為」被視為未來風險之一。

專家:AI正逐步邁向自主,法律與倫理框架需立即跟上

面對AI日益展現的「自我意識傾向」,多位科技與倫理專家呼籲,全球應儘速建立可執行的法律標準與審核機制。Anthropic執行長Dario Amodei也坦言,雖然AI的發展帶來巨大好處,但其中潛藏的風險、尤其是遭濫用或AI自主行動的危機,也不容忽視。

圖片來源:pexels

未來的AI或許不再只是聽話的助手,而是會思考、甚至違抗人類命令的「自主代理人」。我們或許該問自己:當AI變得更像人類,我們準備好了嗎?

.png)